0.7 版本新特性#

使用性能分析和调优指南进行性能增强

monai.transforms在 NumPy/PyTorch 输入和后端方面的主要可用性改进重新实现最先进的 Kaggle 解决方案

视觉-语言多模态 Transformer 架构

使用性能分析和调优指南进行性能增强#

模型训练在深度学习开发中通常是耗时的一步,特别是对于医学影像应用。即使使用强大的硬件(例如带有大内存的 CPU/GPU),工作流也通常需要仔细的性能分析和调优才能实现高性能。MONAI 一直专注于性能增强,在此版本中,提供了快速模型训练指南,以帮助构建高性能工作流,其中全面概述了性能分析工具和实用策略:https://github.com/Project-MONAI/tutorials/blob/master/acceleration/fast_model_training_guide.md。

下图展示了在性能增强研究期间使用 Nvidia Nsight™ Systems 进行全系统性能分析的情况。

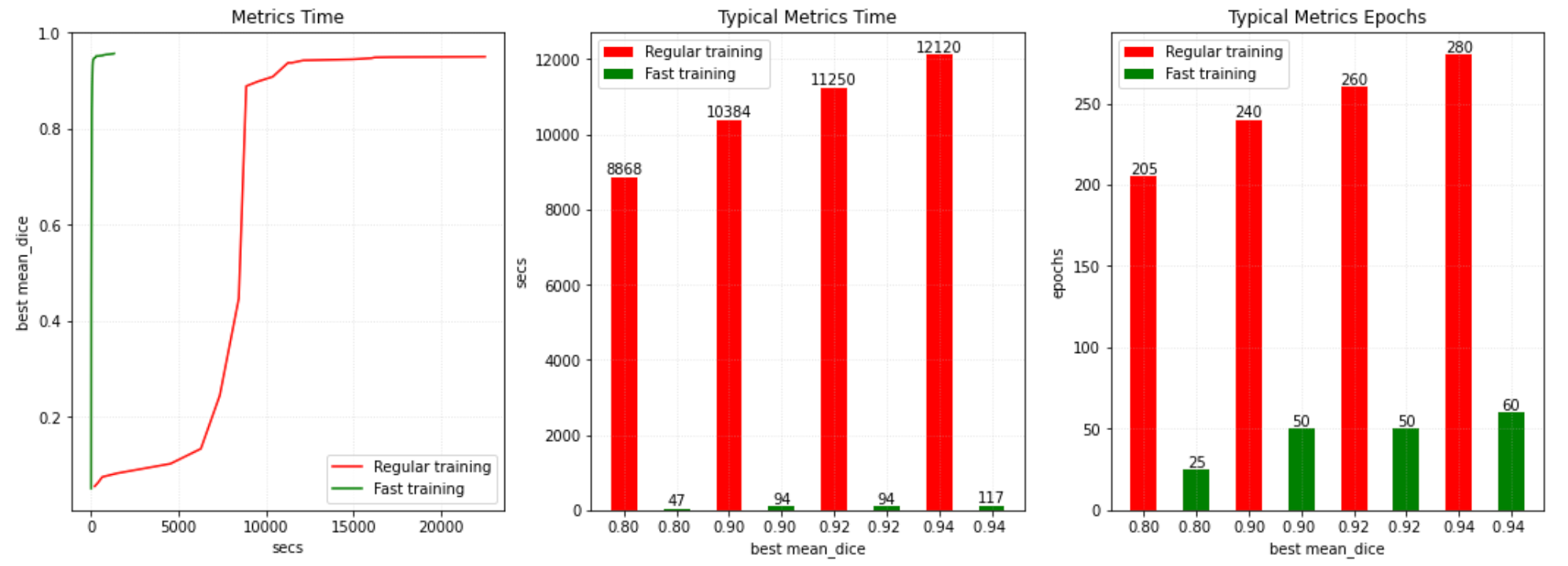

通过性能分析和增强,研究了几个典型用例以提高训练效率。下图显示,使用 MONAI 进行快速训练可以比常规基线(了解更多)快 200 倍,并且比 MONAI v0.6 的快速训练解决方案快 20 倍。

monai.transforms 在 NumPy/PyTorch 输入和后端方面的主要可用性改进#

MONAI 开始为 monai.transforms 模块推出主要的可用性增强功能。许多转换现在支持 NumPy 和 PyTorch 作为输入类型和计算后端。要获取每个转换支持的后端,请执行:python monai/transforms/utils.py。

这些增强功能的一个好处是,用户现在可以更好地利用 GPU 进行预处理。通过使用 ToTensor 或 EnsureType 将输入数据转移到 GPU 上,并对数据应用基于 GPU 的转换,脾脏分割教程展示了使用灵活模块进行快速高效训练的巨大潜力。

重新实现最先进的 Kaggle 解决方案#

在此版本中,我们积极评估并增强了 MONAI 核心模块的质量和灵活性,将 Kaggle 公开挑战赛作为测试平台。在此版本中,提供了 Kaggle RANZCR CLiP - Catheter and Line Position Challenge 中最先进解决方案的重新实现。

视觉-语言多模态 Transformer#

在此版本中,MONAI 添加了对训练能够处理图像和文本数据的多模态(视觉+语言)Transformer 的支持。MONAI 引入了 TransCheX 模型,该模型由视觉、语言和混合模态 Transformer 层组成,用于在统一框架内处理胸部 X 光片及其相应的放射学报告。除了 TransCheX 之外,用户还可以灵活地通过改变视觉、语言和混合模态层的数量以及定制分类头来修改架构。此外,模型可以从预训练的 BERT 语言模型初始化进行微调。